在数字化转型的浪潮中,企业数据资产的价值日益凸显,但数据孤岛、质量参差不齐、安全风险与合规挑战等问题也随之而来。《数据之道》一书明确指出,建立企业级数据综合治理体系是释放数据价值、驱动业务创新的基石。而信息系统集成服务,作为连接技术与业务的桥梁,在这一体系的构建与落地中扮演着至关重要的核心角色。

一、数据综合治理体系:从战略到执行的框架

企业级数据综合治理并非单一的技术项目,而是一个涵盖战略、组织、流程、技术和文化的系统性工程。其核心目标在于确保数据的可用性、完整性、安全性、一致性与合规性,从而为数据分析、智能决策和业务创新提供可信赖的燃料。

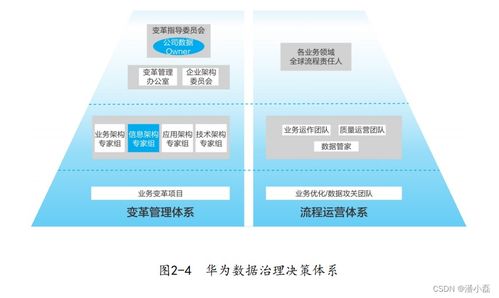

- 战略与组织保障:治理始于顶层设计。需要明确数据战略与企业业务战略的对齐,设立由高层领导挂帅的数据治理委员会,并建立跨部门的数据治理组织(如数据治理办公室),明确各角色(如数据所有者、数据管家)的职责与协作机制。

- 核心治理领域:

- 数据架构管理:设计统一、灵活的数据模型(如主题域、概念模型、逻辑模型),规划数据的分层(贴源层、通用层、应用层)与分布,为数据整合与共享奠定基础。

- 数据标准与质量:制定企业级的数据标准(包括命名、定义、编码、模型等),并建立贯穿数据全生命周期的质量检查、监控、评估与改进闭环。

- 数据安全与隐私:依据法律法规(如GDPR、个保法)和业务需求,对数据进行分类分级,实施差异化的安全策略(加密、脱敏、访问控制、审计),保护核心资产与个人隐私。

- 数据生命周期管理:定义数据从创建、存储、使用、归档到销毁各阶段的策略与规程,优化存储成本并满足合规要求。

二、信息系统集成服务:治理体系落地的“高速公路”

再完美的治理框架,若无法与企业的IT系统和业务流程深度融合,终将是空中楼阁。信息系统集成服务正是实现这种融合的关键使能器。

- 打破数据孤岛,实现互联互通:企业通常拥有众多异构的遗留系统(ERP、CRM、SCM等)和新兴的云应用。集成服务通过API、消息中间件、ETL/ELT工具等技术手段,构建统一的数据交换与共享平台,将分散在不同系统中的数据按治理要求进行抽取、转换和加载,形成可用的数据资源池。

- 承载与执行治理规则:数据标准、质量规则、安全策略等治理要求,必须“编码化”并嵌入到数据流转的各个环节。集成服务流程可以内置数据质量检查点、标准转换映射、实时脱敏逻辑等,确保从源头到消费端的数据都符合治理规范。

- 支持灵活的数据服务与消费:基于集成的数据底座,可以封装形成标准、易用的数据服务(Data as a Service)。这些服务通过API等方式提供给前端业务应用(如数据分析平台、客户画像系统、智能推荐引擎),使得治理后的高质量数据能够安全、高效地赋能业务创新。

- 实现可观测性与持续改进:现代集成平台通常具备强大的监控与日志功能,能够追踪数据血缘、监控数据流性能、审计数据访问行为。这为治理团队提供了宝贵的“数据关于数据”的洞察,用于评估治理效果、定位质量问题根源和持续优化治理策略。

三、实践路径与关键考量

构建以集成服务为支撑的数据治理体系,建议采取迭代、价值驱动的路径:

- 从高价值业务场景切入:避免“大而全”的初期规划。优先选择1-2个业务痛点明显、数据价值高的场景(如客户360视图、供应链透明度)作为试点,快速实现集成与治理,展示成效,获取内部支持。

- 技术平台选型与架构设计:选择支持混合云环境、具备强大连接能力、并内置治理功能(如数据目录、质量规则引擎、主数据管理)的集成平台或数据中台解决方案。架构上应兼顾批处理与实时流处理的需求。

- 组织变革与能力建设:推动业务部门与IT部门的深度融合,培养既懂业务又懂数据的“桥梁型”人才。将数据治理的职责与考核纳入相关岗位的日常工作。

- 持续运营与演进:数据治理非一朝一夕之功。需要建立常态化的运营机制,定期评审治理策略,根据业务变化和技术发展调整集成架构,形成持续改进的文化。

****

企业级数据综合治理体系是数字化转型的“内功”,而信息系统集成服务则是修炼此内功、贯通任督二脉的关键经脉。两者相辅相成,缺一不可。通过将治理理念深度嵌入到从数据源到消费端的每一个集成环节,企业才能将海量、杂乱的数据真正转化为统一、可信、易用的战略资产,从而稳健地驶向数据驱动的智能未来。